Y9T251 AI的胖树拓扑对光模块要求的变化

在大多数光模块厂家比较痛苦的大半年时间里,基于AI的光模块需求带给我们一些光明前景的期望。

今年光博会,大家讨论的AI、800G、LPO、时延....等等

早上略写个文字版本吧,就是光模块不断细分的产业领域里,基于AI人工智能这个数据中心领域的光模块,和传统光模块的一些不同。

※人工智能与数据吞吐量

所谓的人工智能,就是用机器在经过足够的学习和训练后,达到“智能”判断的一个过程。

这个训练和学习,是需要巨大的数据量传递和交互的。

今年很多人举例,用的是GDT 3.5,所需训练的参量达到1750亿,需要45TB的数据量。45T的字节可以换算成bit,比如64位计算机,64位=8字节=8*8 bit。45T的字节量就是45T*8的bit量

要完成这么大的数据量,一个芯片是干不完的,需要成千上万的GPU同时工作。

咱们光模块只管数据的转换,把1bit的电信号转为光信号,把1bit的光信号转为电信号,只是物理转换,不管人家的服务器要干啥。

400G模块,能转换0.4T bit,800G光模块,转换0.8T bit,所以需要多个模块一起完成数据交换。

※人工智能选择GPU型的服务器

因为数据量大,所以用GPU更合适,这就和传统的数据中心的服务器类型有所区别。

比如昨天阿里的报告,以前用x86型的CPU为核心的服务器。而英伟达用的是GPU

CPU是串行运算,GPU是并行运算

CPU,等于光模块研发工程师调测PAM4的眼图,他不光能调试,分析,判断,他能根据TDECQ的大小来思考从哪里优化调整参数,调试出来更高信号质量的,更小的TDECQ。

可这个光模块的研发工程师,硕士,博士,再高的知识调测眼图也是一个一个的调,这是串行运算。如果拿到客户一个30万只光模块的订单,这个博士也不能放到产线去亲自去调测眼图,否则依靠这个博士完成30万只光模块的眼图调测,客户能等到两鬓斑白

GPU,就是产线小姐姐们,不需要知道什么是VCSEL,什么是EML,什么是RIN,什么是TDECQ....,照样可以把光模块调测的好好的。多条产线开工,几千个小姐姐小哥哥们一起并行工作,一个月可以完成五万只800G模块,半年就可以交付30万只。

※基于GPU的方式,对延时的要求极为苛刻

传统的数据中心结构,是基于串行方式的,对时延的要求虽然很看重,但不像AI场景中对时延的苛刻要求。

还是以产线来举例,一个模块的组装,要完成电阻 电容 激光器 探测器 透镜 光纤 外壳 DRV TIA .....无数个光学电学 有源无源的元器件的组装过程,以及参数的配置过程。

这些个工艺节点,你说,一个模块99.9%的节点都完成了,剩下的那个0.1%节点岗位的小姐姐干活很慢,有时延,没有完成。

ok,所有人都得等着这个步骤。

如果成千上万的并行数据要传输,整个数据的完成是以时延最大,最慢的那个bit为准的。其他再快也不行。

咱们的光模块站在整个通信大结构的角度来看,时延是微乎其微的,可毕竟也有时延。

比如,传统热插拔的800G模块有DSP,CPO或者LPO没有DSP,是否选择DSP,这里边就是几十到上百纳秒级延时的概念。

※基于GPU的方式,对光模块的故障率要求极为苛刻

都知道,光模块选择热插拔,是因为光学器件的故障率很高,比传统的电学芯片的故障率要高很多很多,用热插拔方便维修和更换。

传统的数据中心,光模块对于故障率的要求呢,是比传统telecom更宽松的节奏。光模块坏了就换一个呗。

可但是,基于AI的这种场景,就不行,

训练的数据量很大,他不是实时保存的。如果有任何一个数据传错了,那么整体要重来,重新计算一遍。

很多小伙伴会打游戏,如果是非团队作战的这种游戏,你的网络掉线了,那重新上线后,就从上一个保存的节点继续。这是CPU的模式。 虽然可会浪费点时间,可毕竟可控。

如果是50个人组团的大型游戏场景,且规则是,一个人掉线,团队都得陪着重头开始。你会不会瞬间对所有人的网络质量的关注度提高了呢。

※GPU采用的胖树结构的收敛比

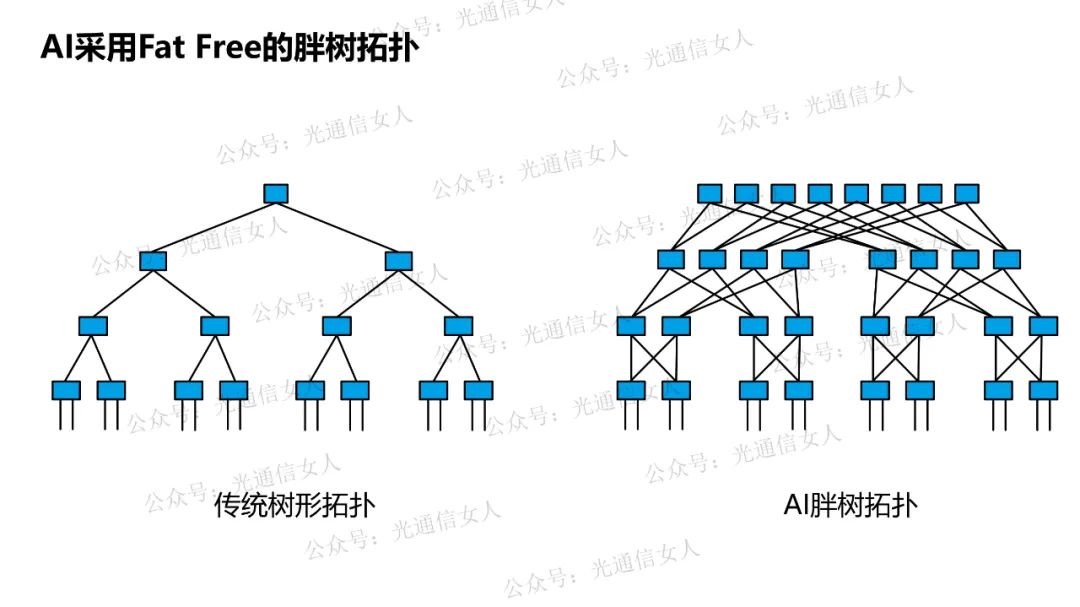

咱们传统的数据中心采用的是树形结构,三级结构的接入-汇聚-核心,二级结构的叶-脊....,他们的根本都是树形拓扑的思路。

而AI是并行计算,是采用胖树结构。也就是Fat Free

下图,节点之间有一条线,假定这条线是光纤,那么这个光纤两头就是光模块。

树形结构是有收敛比的说法,从光模块的角度来看,越接近于服务器的光模块数量越多,越到上层结构,用的光模块数量越少。

可但是胖树结构是没有收敛比的,接入层有多少光模块,汇聚点和核心点,依然还是这么多。

那么,两层交换机,模块数量x2,三层数据交换,模块数量x3,...., 对于光模块而言,还需要双工对传,那么两层节点就是1:4,三层节点就是1:6

所欲AI所需的光模块数量,与节点的关系,是指数上升的数学关系。

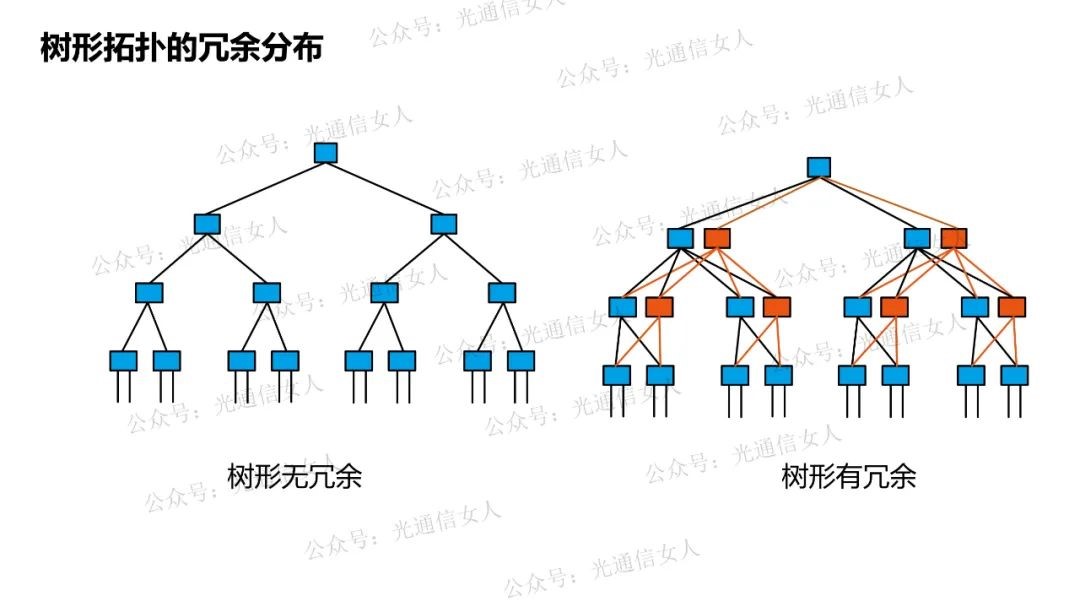

当然,我刚才说的树形是最简易的树形,通常实际部署的树形结构是配置了“冗余的”,传统结构的冗余小一些,超大规模的数据中心的冗余量大一些。

数据中心有冗余的前提下,是放宽了对模块故障率的要求的。冗余越大,意味着,有更多的节点可以实现业务传输,光模块的失效率略大一些是不影响整体通信的。

这就是我们所理解的传统数据中心的光模块,有很长一段时间,是“非气密”封装对不对,因为非气密封装,故障率会高一些。但是也更便宜啊。

但是突然之间,基于AI的这种模式,不仅不能放宽对光模块故障率的要求,还会比原来更苛刻。

这也是突然之间,以前非气密封装技术为主的厂家,比如旭创,开始大规模部署基于气密结构的技术研究。

AI采用的all Reduce的训练模式,并行的GPU服务器,胖树的网络拓扑,对于光模块而言,既看到了大规模部署的市场前景,也感受到提高速率、降低时延,降低失效率的技术压力。

9月19号,9月26号,有两期硅光集成的议题,硅光芯片与铌酸锂的区别,硅光用在LPO、CPO的无DSP的场景,也会和今天聊的光模块有些关系。算是另一个角度的看法吧。 可详询我同事8140517646